Warum Experimentation-Teams diese unterschiedlichen Einsatzmöglichkeiten von A/B-Testing kennen sollten

A/B-Testing ist bei stark wachsenden Unternehmen längst nicht mehr wegzudenken. Es gibt etliche Unternehmen (AirBnb, Booking, Amazon, UBER usw.), die erst durch den Einsatz von A/B-Testing überhaupt ihre Marktdominanz erreichen konnten.

Trotzdem werden Experimente in vielen Unternehmen nicht oder nur sporadisch eingesetzt, um das digitale Business zu optimieren. Woran liegt das?

Die Erfahrungen der letzten 15 Jahre haben gezeigt, dass vor allem fehlende Antworten auf grundlegende Fragen zu den Voraussetzungen und zum Vorgehen am kontinuierlichen A/B-Testing hindern.

Dieser Artikel beantwortet daher die häufigsten Fragen und Gedanken, damit du es leichter hast, dieses sehr mächtige Werkzeug zur Angebots-, Business- und Conversion-Optimierung besser zu verstehen und zu etablieren.

Nachfolgend gehen wir diese grundlegende Fragen beim A/B-Testing durch:

1. Wann sollte ich einen A/B-Test machen?

2. Kriterien, Gründe und Ziele für die Durchführung eines A/B-Tests

3. Statistische Rahmenbedingungen für einen A/B-Test

4. Wichtige Leitfragen für die Durchführung eines A/B-Tests

5. Welche Arten von A/B-Tests gibt es?

6. Fazit: Wie gehe ich nun vor?

Wann sollte ich einen A/B-Test machen?

Auf höchster Ebene betrachtet, löst Experimentieren mittels eines A/B-Test folgendes Problem:

Um das Business voranzubringen und mehr Sicherheit in Entscheidungen zu erhalten, müssen Unternehmen Varianten eines Produktes, Features, Layouts usw. direkt am Kunden validieren. Häufig kommen dabei qualitative Methoden zum Einsatz, um Feedback zu Entwürfen, Prototypen oder Feature-Entwicklungen einzuholen. Der Vorteil ist, dass man bei qualitativem Research sehr tief ins Detail gehen kann, um mehr über die Motivation, Ängste und Haltungen der Nutzer zu erfahren.

Wenn du dann allerdings Änderungen an deiner Website oder deinem Produkt vornimmst, ohne zu messen, wie sich das auf wichtige KPIs auswirkt, wirst du nie erfahren, ob deine Maßnahme wirklich zielführend (im Business- oder UX-Kontext) gewesen ist.

Genau das ermöglicht ein A/B-Test. Ein Experiment im “Live-Betrieb” an dem 10-Tausend, 100-Tausend oder mehr Nutzer teilnehmen.

Diese quantitative Analyse der “Varianten” hat eine andere Aussagekraft und einen anderen Wert als 10 “Einzelmeinungen” aus einem Usertest. Das heißt nicht, dass du mit User Research aufhören solltest. Im Gegenteil: User Research ist eine großartige Quelle für Testideen und Hypothesen. Und nicht jede Änderung kann einfach so in einem A/B-Test umgesetzt werden, z.B wenn sich die Variante noch in einem sehr frühen Stadium befindet (Wireframes, erste Designs).

Dennoch gilt: Nur durch das Validieren von Änderungen mittels Experimenten (A/B-Test, Split URL Test, multivariater Test) können wir etwas über die messbare Veränderung im Kunden- und Kaufverhalten lernen. Denn die Nutzer wissen nicht, dass sie in einem Test sind und reagieren deswegen vollkommen “authentisch”.

Auch wenn nicht jeder Test einen Uplift und eine Gewinnervariante hervorbringt, wirst du bei richtigem Testdesign und mittels der richtigen Hypothesen IMMER etwas über deine Kunden erfahren können.

Um dir einen schnellen Einstieg zu geben, starten wir mit den beiden häufigsten Fragen zum Thema A/B-Testing, die uns in den letzten 15 Jahren gestellt worden sind.

Häufige Frage Nr. 1: “Müssen wir wirklich ALLES testen – sprich jede Änderung auf der Webseite in einen A/B-Test geben?”

Antwort: Es gibt da draußen etliche Unternehmen, die dies tatsächlich als Philosophie betreiben (Bsp: Booking.com oder Bing). Hier wird jede Änderung am Code der Website getestet. In der Praxis ist dies jedoch für viele schwierig, entweder weil die technische Infrastruktur nicht gegeben, die Ressourcen nicht reichen oder der Traffic schlichtweg weit vom Niveau der “Großen” entfernt ist.

Wir empfehlen daher jedem Unternehmen, die genannten Faktoren zu berücksichtigen und

entwickeln individuelle Anforderungen, damit A/B-Testing als gewinnbringende Methode eingesetzt werden kann. Die wichtigsten Leitfragen für diese Anforderungen an einen A/B-Test findest du etwas weiter unten.

Häufige Frage Nr. 2: “Kann ich statt zu testen nicht einfach deployen und im Analytics schauen wie sich die Conversion Rate entwickelt?”

Antwort: Nein, weil zwei Zeiträume nie 100% miteinander vergleichbar sind. Der kausale Zusammenhang zwischen dem Zeitreihenvergleich in den Analytics-Daten und deinen Änderungen an der Website ist nicht voll gegeben.

Wenn du also wirklich messen willst wie der Verhaltensunterschied ist, bleibt dir nichts anderes übrig, als ein kontrolliertes Experiment durchzuführen. Beide Varianten haben so gleiche Bedingungen (Traffic-Mix und -qualität, Saisonalität usw.). Nur so kannst du eine “Ursache > Wirkung”-Beziehung herstellen.

Zurück zur Ausgangsfrage: “Woher weiß ich, dass ein A/B-Test die richtige Wahl für meine geplante Maßnahme ist?”

Kriterien, Gründe und Ziele für die Durchführung eines A/B-Tests

In der Praxis haben sich unter anderem folgende Kriterien als gute Auslöser für die Durchführung eines A/B-Tests herauskristallisiert:

1. Verbesserung der wirtschaftlichen Leistung, CX und Marketing-Effizienz

Maßnahmen mit dem Ziel einer Verbesserung der Customer Experience, Marketing-Effizienz oder wirtschaftlichen Leistung (= mehr Sales, Umsatz, Leads, usw.) sind ideale Kandidaten für das A/B-Testing. Bei diesen “vertrieblichen” Maßnahmen ist erfolgsentscheidend, wie die Kunden auf die Änderung reagieren. Daher steht hier eine gute Analyse & Hypothesenentwicklung im Zentrum, um die Wahrscheinlichkeit zu erhöhen, dass die Änderung im A/B-Test tatsächlich die gewünschte Metrik (z.B. Conversion Rate) nachweisbar “anhebt”. Der Einsatz von A/B-Tests in diesem Kontext hat den Begriff “CRO (Conversion Rate Optimization)” geprägt, obwohl in der Praxis eine Optimierung von weit mehr als “nur” der Conversion-Rate stattfindet.

2. Akzeptanz-Messung neuer Produkte, Features oder Pricing-Anpassungen

Ein A/B-Test eignet sich ebenso, um das Interesse an neuen Produkten oder Features zu messen. Hierbei kommen häufig sogenannte Smoke-Tests zum Einsatz. Der Smoke-Test beschreibt ein Experiment, bei dem ein Produkt, ein Produktfeature oder ein neues Geschäftsmodell auf deinem Touchpoint angepriesen wird, obwohl dieses noch gar nicht existiert. Sobald z.B. der Klick/die Auswahl stattgefunden hat, löst sich das ganze “sprichwörtlich” in Rauch auf und du präsentierst dem Kunden eine “Auflösung”. Ein Beispiel: Gerade im SaaS-Bereich ist die Preis- / Tarifgestaltung der zentrale Optimierungshebel. Durch sog. Smoke-Tests findest du heraus, wie Kunden auf eine Änderung reagieren, noch bevor du tatsächlich die Preise angepasst oder ein Feature entwickelt hast. Mehr zum Thema Smoke-Tests gibt es hier.

3. Absicherung von Website-Relaunch und Redesigns

Die Annäherung an Redesigns durch Experimente, um den Einfluss auf die Business-KPIs zu messen hat sich als Best Practice etabliert. Im Fokus steht hier nicht immer ein Uplift. Oft reicht bereits die sichere Gewissheit, dass keine Umsatzeinbrüche zu vermuten sind, weil z.B. die Bestandskunden gegen die neue Optik rebellieren. Amazon führt z.B. keine radikalen Redesigns durch und hat die Website über die letzten Jahrzehnte Stück für Stück verändert und Änderungen immer in Experimenten validiert.

4. Proof-Of-Concept für den Einsatz von Tools, Zahlungsdienstleistern und co.

Oft gehen Tool-Anbieter und Zahlungsdienstleister mit sehr hohen Versprechungen in Gespräche rein. Dagegen ist erstmal nichts einzuwenden. Da aber jeder Shop sowie die Zielgruppe unterschiedlich ist, empfiehlt sich der Einsatz von Experimenten, um den ROI deiner Ausgabe sicherzustellen. Führt die neue Recommendation Engine wirklich zu gesteigerten Warenkorb-Werten? Nutzen wirklich genügend Kunden das neue Zahlungsmittel und wie verändert sich durch die Kosten (Gebühren) der Deckungsbeitrag? Ein A/B-Test zum Proof-Of-Concept schafft hier Gewissheit.

Statistische Rahmenbedingungen für einen A/B-Test

Neben den Kriterien unter Punkt 2 gibt es außerdem statistische Rahmenbedingungen, die erfüllt sein müssen, damit man überhaupt ein Ergebnis bekommt, dass eine Entscheidung für oder gegen eine Variante ermöglicht.

Genauer gehen wir in diesem Artikel nicht darauf ein, dafür gibt es z.B. unseren “Statistik Spickzettel für Optimierer”. Es reicht an dieser Stelle zu sagen, dass es eine bestimmte Stichprobengröße braucht, um Uplift-Effekte nachweisen zu können. Mit Stichprobe ist zum einen der Traffic (= Anzahl Unique Visitors) als auch die Conversions (Anzahl Sales, Leads, Clicks usw.) gemeint.

Wenn der zu testende Touchpoint keine ausreichende Stichprobe besitzt, besteht die Gefahr, nur gigantische Effekte (die anders als in vielen Case Studies propagiert super unwahrscheinlich sind) oder gar nichts nachweisen zu können. Damit misst du zwar eine Änderung, kannst aber nicht mit Sicherheit sagen, ob eine Variante wirklich besser ist.

Wieviel Traffic genug Traffic ist, dass solltest du individuell berechnen (nutze den Testlaufzeitrechner). Unterhalb von 1.000 Conversions im Monat wird es dir jedoch sehr schwer fallen, kleinere Effekte nachzuweisen.

Wichtige Leitfragen für die Durchführung eines A/B-Tests

Um die konkreten Kriterien für einen A/B-Test zusammenzufassen, findest du nachfolgend eine Liste der wichtigsten Fragen bzw. Situationen, für die Testing eine geeignete Lösung ist.

- Haben meine Maßnahmen ein Ziel, dass sich messen lässt?

- Kann kurzfristig eine Veränderung in der zu beeinflussenden KPI nachgewiesen werden (Traffic, Rahmenbedingungen)?

- Habe ich eine Hypothese über meine Kunden, die ich bestätigt / widerlegt haben möchte?

- Möchte ich konkret erfahren, wie sich das Verhalten der Kunden ändert, wenn ich meine Änderung / Kampagne usw. ausspiele?

- Habe ich ein Interesse, den wirtschaftlichen Effekt einer Maßnahme (Zusammenhang zw. UX und Business-Erfolg) möglichst eindeutig nachweisen und reporten zu können?

- Gibt es Bedenken oder Unsicherheiten, dass eine Maßnahme einen negativen Einfluss auf die Business KPIs haben könnte und muss ich das absichern?

- Brauche ich Zahlen, die einen Business Case untermauern / bestätigen?

- Liegt eine strategische Entscheidung bei meinem Produkt (z.B. Pricing) vor, die direkt am Kunden validiert werden soll?

Für viele Maßnahmen im digitalen Marketing, für digitale Geschäftsmodelle, für digitale Produkte werden gleich mehrere dieser Fragen mit “JA” beantwortet werden. Je mehr Antworten sich mit einem “JA” ergeben, desto besser eignet sich ein A/B-Test.

Wann sollte man NICHT A/B-Testen?

Natürlich gibt es auch Themen, bei denen sich ein A/B-Test nicht eignet.

In frühen “Entwicklungsstadien” deiner Variante kann User Research die bessere Methode sein kann.

Auch das Fixen von Bugs ist in den allermeisten Fällen keinen A/B-Test wert. Hiermit schafft man zwar sicher ein paar schnelle Uplifts, aber beweist sich letztendlich nur, dass eine funktionierende Webseite besser konvertiert.

Auch wenn Änderungen so klein sind, dass ein Effekt nur sehr schwer / nach sehr langer Zeit oder gar nicht nachgewiesen werden kann, verschwendest du lediglich wertvollen Traffic und kannst trotzdem keine wirtschaftliche Entscheidung treffen. Deshalb berücksichtige die statistischen Rahmenbedingungen.

Welche Arten von AB-Tests gibt es?

A/B-Testing ist der bekannteste Begriff für das Validieren von Änderungen in Experimenten, tatsächlich gibt es jedoch verschiedene Formen von “A/B-Tests”.

Damit du dich bewusst für die richtige Art von Test entscheiden kannst, hier ein Überblick der Arten von A/B-Tests, zwischen denen wir unterscheiden müssen.

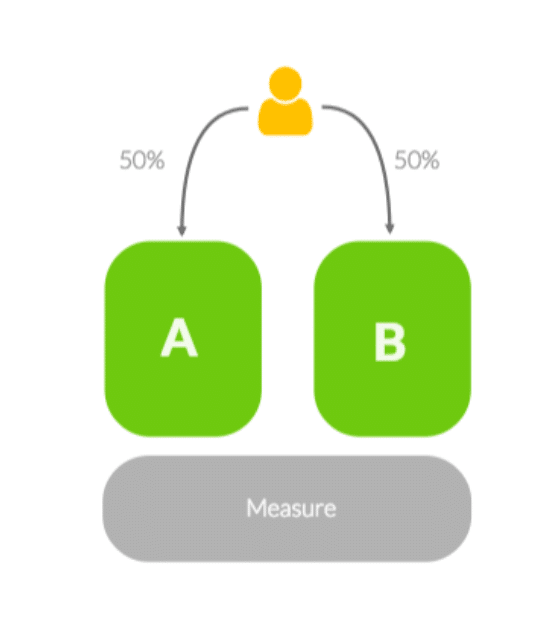

Der klassische A/B-Test

Dies ist die “einfachste” Form des Testens mit zwei Varianten.

Variante A: die aktuelle Version deiner Website/E-Mail etc. , wird in der Conversion Optimierung auch “Control”, “Original”, “Baseline” oder “V0” (für Variante 0) genannt

Variante B: die veränderte Version, auch “Variation”, “Variant”, “V1” (für Variante 1), oder “Challenger” genannt

Im Normalfall wird der Traffic zwischen diesen beiden Varianten gleichverteilt, also 50% A und 50% B. Der Vorteil: durch die geringe Zahl an Varianten erhältst du schneller verlässliche Ergebnisse (vorausgesetzt, du verfügst über ausreichend viel Traffic).

Die Entscheidung auf Basis der Zahlen zu treffen fällt leicht, da Variante B entweder “gewinnt” und damit zum Rollout empfohlen werden kann, oder kein signifikanter Unterschied gemessen wurde, weswegen alles “beim alten”, und die “Control” (A Variante) weiterhin live bleibt.

Möglicherweise performt Variante B sogar schlechter (keine Panik, dafür testen und lernen wir daraus, statt einfach auszurollen). Auch dann kann das Experiment nach ausreichendem Daten-Sammeln abgestellt werden und es wird sofort wieder die “Control”-Variante an 100% der Nutzer ausgespielt. Der Schaden durch ausgerollte Änderungen, die einen negativen Business Impact haben wird also nicht nur messbar sondern auch minimiert.

Nachteil: Durch den Test einer einzigen “Alternative” musst du aufpassen, wie viele Änderungen du gleichzeitig machst, bei zu vielen Änderungen kannst du die Ergebnisse nicht mehr exakt auf diese zurückführen und verzichtest damit (bewusst) auf Lerneffekte über das Kundenverhalten im Detail.

Allerdings bietet eine Variante mit mehreren Änderungen ggf. auch mehr Potenzial eine Steigerung in der relevanten KPI zu erzeugen, sodass du schneller mit der Optimierung “vorwärts” kommst. Gute Optimierer finden eine Balance aus der Granularität der Änderungen und dem Fokus auf zeitnahe Steigerung der Business-Ziele

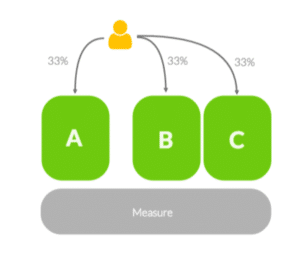

Der A/B/n-Test

Ein A/B/n-Test ist nichts anderes als ein A/B-Test, bei dem mehr als eine Variante der Control gegenübergestellt wird. Auch hier wird der Traffic fast ausnahmslos gleichverteilt. Hierbei besteht entweder die Möglichkeit, dass Varianten in ganz unterschiedliche Richtungen gehen (verschiedene Hypothesen, Prinzipien), oder die Varianten Abwandlungen der Hypothese sind, um herauszufinden welche Ausprägung am besten funktioniert (z.B. verschiedene Headlines, Preiskommunikation oder Value Propositions). Mehr dazu findest du im Beitrag “Goldene Zirkel” der Conversion Optimierung.

Vorteil: Durch das Testen von verschiedenen Varianten erfährst du in kurzer Zeit mehr über das Nutzerverhalten.

Nachteil: Je mehr Varianten du testest, desto länger braucht dein Test (bei gleichem Traffic), um eine valide Aussage über die Ergebnisse zu liefern (valide = signifikant im mathematischen Sinne + ausreichend Stichprobe für ein verlässliches Ergebnis).

Zudem musst du auf die sogenannte “Alpha-Fehler-Kumulierung” aufpassen. Das Risiko einen signifikanten Gewinner aus “reinem Zufall” zu finden, erhöht sich nämlich mit der Zahl der Varianten. Auch die Entscheidung, eine Variante zum Roll-Out zu empfehlen, wird ggf. etwas komplexer, z.B. wenn gleich zwei oder mehr Varianten gegenüber der Control gewinnen und du dich für einen der “Gewinner” entscheiden musst.

Vielleicht fragst du dich danach auch “Wäre eine Kombination aus Variante C und D nicht dann noch besser, als einfach nur die mit dem höheren Uplift von beiden auszurollen?” Dann kann dir die folgend beschriebene Art des A/B-Tests weiterhelfen.

Der Multivariate Test (MVT)

Ein Multivariater Test hat zum Ziel, die Wechselwirkung von Änderungen (in der Wissenschaft “Variablen” genannt) und Kombinationen von Änderungen im Detail auswertbar zu machen.

Auch wenn wir in der Praxis nicht empfehlen, MVTs in unzähligen Kombinationen zu testen (warum erfährst du weiter unten), gibt es Situationen, in denen ein Multivariater Test sinnvoll ist.

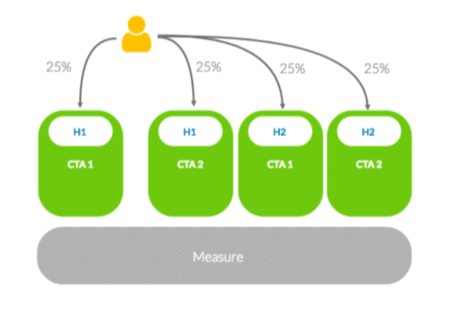

Das “Button/CTA”-Experiment ist ein gutes Beispiel, um den Multivariaten Test zu erklären:

- Stell dir vor du möchtest Farbe und Formulierung deiner CTA verproben, weil du annimmst, dass sich dadurch die Clicks auf den Button erhöhen.

- Du könntest jetzt entweder, zuerst die Farbe testen und dann die Wordings (in 2 A/B/n-Tests). Doch was, wenn Wording und Farbe sich gegenseitig beeinflussen und Du am Ende eine mögliche beste Kombination nie getestet hast?

- In einem Multivariaten Test gibst du dem A/B-Testing Tool vor, welche Farben und welche Formulierungen du alle testen möchtest und das Tool verteilt den Traffic automatisch auf alle möglichen Kombinationen aus Farbe+Formulierung.

Vorteil: Dir geht keine Kombination unter und du erhältst möglichst hohe Klarheit über den Zusammenhang mehrerer Änderungen zu deinen Zahlen.

Nachteil: In der Praxis bergen MVT Tests eine große Gefahr: Durch die oft sehr vielen Varianten (wir haben alles von 10 bis 100+ schon gesehen) benötigt so ein Test extrem viel Traffic und sehr viele Conversions und damit SEHR LANGE um überhaupt gescheite Ergebnisse zu liefern.

Wie schnell die Zahl der Varianten steigt kannst du dir ganz leicht selbst ausrechnen ([# Varianten von Element A] x [# Varianten von Element B] x … = [# Varianten insgesamt]). Eine Signifikanz wird bei dieser hohen Zahl an Varianten (siehe “Alpha Fehler Kumulierung) oft zufällig erreicht und man glaubt einen Gewinner gefunden zu haben, die Ergebnisse sind aber nicht belastbar (Valide).

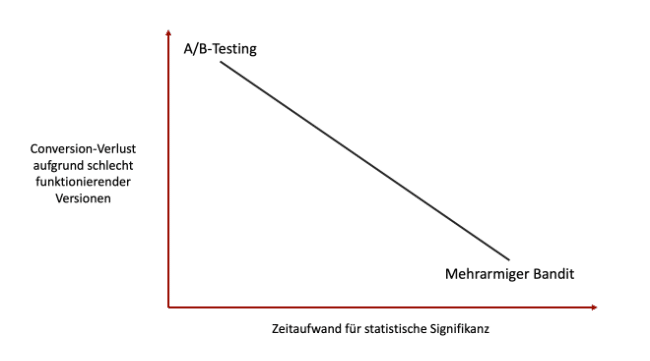

Multi-Armed-Bandit Test (mehrarmiger Bandit)

Wie du der Grafik entnehmen kannst, gibt es einen eindeutigen Zusammenhang zwischen der durchschnittlichen Konversionsrate und der Zeit, die zur Feststellung der statistischen Signifikanz benötigt wird. Wenn zudem die Conversion Rate verschiedener Versionen ähnlich ist, verschwinden die Vorteile mehrarmiger Bandit-Algorithmen.

Das einzige Szenario, in dem mehrarmige Banditen-Algorithmen am besten funktionieren ist, wenn die Leistung verschiedener Versionen massiv unterschiedlich ist (was in der Praxis nur selten vorkommt).

Selbst in solchen Fällen, da der Unterschied massiv ist, würde eine einfache Randomisierung die statistische Signifikanz recht früh erkennen, so dass du in der restlichen Zeit einfach die Version mit der besten Leistung verwenden kannst.

Profi-Tipp für eine gute Balance aus Testlaufzeit (Geschwindigkeit) und Learnings (Detailauswertung einzelner Änderungen)

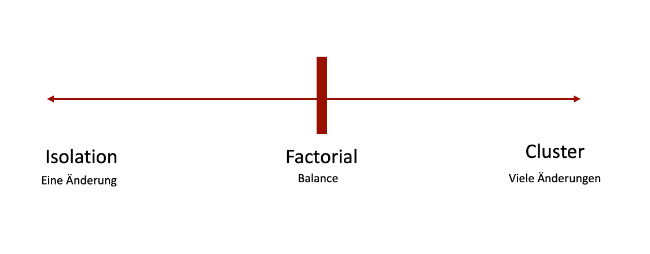

Es lassen sich auch Aspekte aus A/B/n-Test und Multivariaten Test zusammenbringen. Gemeint ist damit das “faktorielle” Design von Experimenten. Dabei testest du nicht ALLE kombinationsmöglichkeiten eines MVT, sondern kombinierst und isolierst gezielt Einzelmaßnahmen um die wenigen, wichtigsten Varianten getrennt zu verproben.

Wenn du z.B. die Website in der ersten Variante umgestaltet hast, könntest du in der zweiten Variante isoliert weitere Value Propositions mit aufführen. Auf diese Weise kannst du Änderungen von Varianten zusammensetzen und gleichzeitig gegeneinander testen, statt alle Varianten gegen die Control zu testen.

Sequentielles und paralleles Testing

Nachdem du jetzt viele Dinge über den Aufbau eines einzelnen A/B-Tests weißt, bleibt nur noch die Planung mehrerer Tests, damit aus deinem Optimierungsvorhaben auch ein echtes “Programm” wird. Neben Fragen rund um die Priorisierung (Welchen Test mache ich zuerst? Welchen als nächstes?) begegnet uns in der Planung noch ein weiteres Thema:

“Sollte ich immer genau einen Test nach dem anderen machen? Oder Kann ich auch mehrere Tests gleichzeitig laufen lassen?”

Auf alle Einzelheiten zum Thema paralleles Testing hier einzugehen, würde den Rahmen dieses Artikels sprengen. Zusammengefasst lässt sich sagen: Gleichzeitiges Testing auf verschiedenen Produkt-Funnels (Bsp: verschiedene Versicherungsprodukte einer Direktversicherung) stellt kein Problem dar, wohingegen im eCommerce und bei Websites mit nur einer “Abschluss”-Conversion (Kauf, Lead, o.ä.) einige Fallstricke existieren. Nutzer werden dann ggf. Teilnehmer in mehreren Experimenten. Damit können die Ergebnisse der jeweiligen Testvarianten von einer leichten Unsauberkeit aufgrund der nicht mehr eindeutigen Zuordnung, bis hin zur deutlichen Verzerrung beeinflusst sein, was die Ergebnisse nur bedingt interpretierbar macht.

Daher unsere Empfehlung: Versuche dein Programm erst einmal so auszubauen, dass wirklich zu jeder Zeit mindestens 1 Test läuft, du also möglichst keinen Traffic “verschwendest” durch Pausen zwischen 2 Tests. Erst dann brauchst du dich überhaupt damit beschäftigen, wie du saubere Ergebnisse bei parallel laufenden Experimenten sicherstellst.

3 Ideen bzw. mögliche Testszenarien:

- Gegenseitiger Ausschluss der A/B-Tests (jeder Nutzer kommt nur in 1 Test, was den Traffic beider Experimente reduziert).

- Gleichzeitiges Testing auf verschiedenen Customer Journeys (z.B. 1x SEO Einstieg, 1x Brand Keywords)

- Gleichzeitiges Testen auf verschiedene KPIs, die im zeitlichen Verlauf (z.B. einer Session) weit genug voneinander weg sind (z.B. A/B-Test 1: Startseiten-Experiment mit Ziel einer höheren Click-Through-Rate auf Kampagnen-Teaser, A/B-Test 2: Trust Elemente im Warenkorb mit Ziel die Anzahl der Nutzer zu erhöhen, die einen Kauf tätigen.)

Du möchtest noch mehr über Testing lernen? Keine Angst vor der Kultur des Experimentierens! Gerne kannst du dich für das Growth Ambassador Programm bewerben, um dich mit anderen Expert:innen unserer Community in regelmäßigen Meetups über A/B-Testing auszutauschen. Es wartet zudem ein sehr interessantes Video auf dich, das dir zeigt, wie du in der Praxis erfolgreich experimentierst.

Fazit + wie es weitergeht

Du kennst jetzt alle Grundlagen, um A/B-Testing als Methodik zu verstehen. Außerdem hast du nun wichtige Kriterien zur Hand, um zu entscheiden, wann ein A/B-Test für dich sinnvoll ist.

Der nächste Schritt: Damit deine A/B-Tests erfolgreich werden, gehört natürlich noch etwas mehr dazu. Denn wie bei allen Optimierungsmaßnahmen gilt: Müll rein – Müll raus. Neben der korrekten Durchführung des A/B-Tests und des Prozesses im größeren Sinne ist die Generierung guter A/B-Test Hypothesen ganz oben auf der Liste der Erfolgsfaktoren für wirksames gutes A/B-Testing.

Denn dein Ziel sollte es sein, nur Experimente zu fahren, die einen Lerneffekt und oder Uplift erzielen. Meine Empfehlung an dich lautet also mit dem Themen “Hypothesengenerierung” und Hypothesen-Priorisierung weiterzumachen.

Hast Du noch Fragen zum Thema A/B-Testing die dieser Artikel nicht beantwortet? Ab damit in die Kommentare, dann gehen wir gerne darauf in einem Update ein oder kommen persönlich auf dich zu.

Danke für dein Feedback und viel Erfolg beim Testing.